ロボットによる過失の法的責任は誰にあるのか?

昨年、EUがロボットに対して「電子人間」という法的地位を与えるべき、とする法整備の議論が展開されて話題になったのをご存知でしょうか。電子人間、原文ではelectronic personsです。エレクトロニック・パーソン…SF好きな私としては、この単語を聞いただけでとりあえず人間が絶滅寸前まで追い込まれて最終的に動物園に入れられるところまでシナリオを妄想してしまうわけです。が、EUによるこの提案に危惧を覚えたのは私のような妄想屋さんだけではなく、AIやロボティクス、法律に倫理学の専門家たちも同様のようです。そして先日、14カ国の国から150人以上の専門家がこのEUの提言を批判する公開書簡に署名をしました。

EUの主張はこの法的地位を与えることで、ロボットが何らかの問題を起こしたときに誰の責任であるかを明確にすることが容易になる、というものです(後述しますが、ロボットに人権を与える、という意味ではないので注意です)。しかし「ロボットに人間としての法的地位を与えるのは時期尚早だ」「この法案によって製造者たちの責任がなくなってしまう」という懸念が表明されています。

EUの提案は、ロボットの「法人」化に近い

議会によると、この法律はスマート・ロボットに適用されるとのこと。彼らの定義によると、体験とやり取りから学習する能力や、センサーを利用して自律性を獲得する能力、さらに環境に適応して行動を修正する能力を持つ、といった条件を満たしたロボットがスマート・ロボットに値するようです。

もちろん、EUが懸念している事態も理解できます。ロボット分野における技術発展は、目覚ましいものがありますから。ロボットが人間に対して反乱を起こすような事態の想定ではなく、自律走行の車やドローンが人間に危害を加えてしまった場合や、工場で作業中のロボットが注意が散漫な人間スタッフに危害を加えてしまった場合に対応できるようにならなくてはいけない、という危機感を持っているわけです。たしかにこれはこれで、重要なポイントですよね。

ロボットやAIがあらゆる場面で普及するにつれて、こういった事故は必ず増えてくるでしょう。その場合の責任がすべて製造元にあるのか、所有主にあるのか、それともロボット自体にあるのか、これら複数の要素が合わさった形になるのか。議論を進める必要があるわけです。特に技術が高度に、自律的になるにつれて一般消費者にとってロボットの仕組みを理解することはどんどんと困難になるでしょう。専門家ですら、人工知能が何らかの判断を下したときにその理由(思考回路)を知ることは困難になります。いわば、ロボットのブラックボックス化ですね。

そんななかでロボットが問題を起こしたとき、原因を知ること、誰に責任があるのかを探ること、が難しいことは想像することは容易です。

そこでEUが提案したのが電子人間という法的地位でした。もちろんこれは、ロボットに投票や所有権といった権利を与えることを意味しているわけではありません。また、ロボットに「意識」があると認めるわけでもありません。むしろこれは、会社が持つ法人ステータスに似ています。

法律上、人間が所有する権利の一部を「会社」という単位で持つことを社会は認めています。だから、法律上の人格を持つ存在として法人と呼ばれるわけです。最近では自然界の川や森にも法人のステータスを与えるという試みも見られます。例として、ロボットを法人として認める、といわれるとたしかに納得できそうですよね。電子人間という響きからはかなり違ったものが想像できます。

専門家の懸念は責任者の不透明化

電子人間のステータスを持つことで、スマートロボットは法律の下にある存在になります。つまり、各個体で社会的責任や義務を持つことになるわけです(それが具体的にどのようなものになるかはまだわかりません)。まさにこれは「法人」扱いをされる会社のようなものです。そしてこれにより、責任はロボット自体に宿るようになります。もちろんロボットを刑務所に入れる形で責任を取らせることはできませんが、すべてのロボットは独立した存在として、保険に加入していないといけない、といった義務を課すことが可能になります。だからこそ、専門家たちが「製造元の責任を消してしまう」と危惧されているんです。

たとえば、工場のように利益を生みだすためにロボットが使われる場合、強制加入の保険システムの資金はロボットが生みだす収益から集めることもできる、とPoliticoでは述べられています。

また、今回のEUの提言では、人間によるサポートを前提とした特定のマシーンに対して独立した法的立場を提供すると述べられています。しかし、独立や人間による後援、と互いに矛盾するかのような表現でまとめられているにも関わらず、具体的にどのような条件を指すのかは曖昧なまま。このまま会社法人のようなものになってしまうと、かなり複雑な事態になってしまうでしょう。

アメリカに関していえば、会社法人は訴訟を起こすことも訴えられることも可能です。法律上の契約を結ぶこともできますし、規制の対象にもなります。しかし実際の所有者や従業員は、その法人の危害に対する責任から免れます。なるほど、だから「製造元の責任が消えてしまう」と公開書簡では批判されているわけですね。

専門家の見解は? 今後に備えて必要だけど…

フランス国立科学研究センターの倫理委員会所属、法律専門家のNathalie Nevejansさんをはじめ、責任あるロボティクス財団(Foundation for Responsible Robotics )のAI/ロボティクス教授Noel Sharkeyさん、IEEEロボティクス・オートメーション協会の元会長であるRaja Chatilaさんといった専門家たちなど、156名もの専門家たちが公開書簡に署名しています。

彼らも、今後やってくる高度なロボット時代に備えて人間を保護するために法整備が必要であることは同意しています。ただ、自律学習をし、自動で動くマシーンが何か事故を起こしたときにどこに責任があるのかを解明するのは不可能になると主張しています。

技術的な観点から見て、(EUによる)提言は、ロボットが実際にできることを過剰に高評価している。これは最も高度なロボットに照らし合わせてもいえることだ。自律学習性能、予測不可能性に関する理解も、極めて表面的だ。SFによって歪められたロボット観と、最近のプレス発表でセンセーショナルに煽られたプロモーションなど、これらの誤った多くの偏見に基づいている

責任あるロボティクス財団は、書簡でこのように指摘。米Gizmodoが取材したハーバード大学のロボット倫理学専門家Kate Darlingさんは、以下のように述べています。

ロボットの法的なステータスは、近代法における「自然人」モデルに基づいてはいけない。そうするとロボットは尊厳、公正さ、報酬、市民権といった人権を所有することになる。これは人間の権利と直接衝突することになる。さらに、そのことは欧州連合基本権憲章、人権と基本的自由の保護のための条約に反する。

また、ロボットの法的ステータスは「法人」モデルにもとづいてもいけない。このモデルは法人を代表する、もしくは管理する人間の存在を示唆するからだ。これはロボットに関しては真ではない

Darlingさん自身はこの公開書簡には関わっていませんが、現時点でロボットに電子人間のステータスを与えても意味がない、と指摘しています。

まず第一に、EUの提言は製造者たちに誤ったインセンティブを与えてしまうでしょう。次に、予測不可能な行動がなぜ新しくて解決不可能な問題として心配されているのか、私には理解できません。私たちのペットの猫も自律的な判断を下しますが、その行動に対する責任を猫に課すことはしません

いっぽう、Global Catastrophic Risk研究所の研究員であるSeth Baumさんは、ロボットや知的なマシーンが電子人間のステータスを有することにメリットがあると「原理的には」考えています。ちなみに彼も公開書簡には関わっていません。政府が電子人間というコンセプトを検討すること自体に、「喜びを持って驚いている」と彼は答えました。とはいえ、彼も急いで結論を出そうとすることには危惧を持っているようです。

今日のロボットや知的マシーンはほぼ確実に、どのような合理的なスタンダードを持ってしても、(電子)人間のステータスを得るには単純すぎます。さらに、ロボットや知的マシーンに対しては異なる形式の「人間」ステータスが必要になるでしょう。異なる権利や責任を持つ形態です。特に、大量に製造され複製が可能であることを考慮すると、投票権といった権利を彼らに拡大して与えることには極めて慎重になるべきです。今、これらの議論を行うべきですが、最終判断を下す時期ではありません

フロリダA&M大学のロボット倫理学と哲学専門家であるMichael LaBossiereさんは、米Gizmodoに対しこのように答えました。

ロボットは今、「電子人間」のステータスを与えられるべきではありません。現時点で存在しているロボットでそれに適しているものは一つも無いからです。

しかし、倫理的な面から法の問題について今解決するべきで、これまでのように悲惨な事態に突入してから解決しようとするアプローチは避けるべきです。そういう意味で、人工知能の未来に備えて法的な基盤を今整えるということには賛成です

はたしてロボットが人間と同じ意味で「知性」を持つことがあるのでしょうか? この問いに対し、LaBossiereさんは「意識が存在するのは有機体の中でないといけない」とする説得力のある理由は存在していないといいます。

有機体の塊が思考することができるなら、回路や人工的な塊が思考することができる、と考えるのはそれほどおかしくはありません。思考するためには魂が必要だ、と考えている人にいいたいのは、肉の器に魂が存在していることは金属の器に存在することに比べて特に奇妙なわけではない、ということです

Ethics and Emerging Technologies研究所所属の社会学者であり未来学者であるJames Hughesさんは、最終的にはロボットも電子人間のステータスを得る可能性があることに同意しています。そして今回の公開書簡の文面がその可能性を排除してしまっていることに危惧を抱いています。また、彼はこのように語っています。

現在のロボットに関しては倫理的な根拠がなく、権利を持つべきとは見なせない、と示唆している点に関してはこの文書は正しいと思います。しかし将来的にはそれが実現する可能性があることを完全に拒否しているという点で、間違っているんです。

事実、彼らの「ロボットに人間の権利を与えることが人間の権利を侵害してしまうだろう」という論理は理に適っていません。

現状の権利にまつわる宣言は、人間のみが権利を持つことができるという意味で差別的だ、というならそれは正しいでしょうが。

しかし、これは過去にも人種差別的な法律が存在し、それらが非倫理的であった、というのと同じです。ロボットの権利が人間が行使する権利と衝突するかもしれない、というなら、それはあらゆる権利に関していえることでしょう。

未来のロボットは十分に人間と同様であり、故に権利を持つことが可能かもしれない。そうなれば、彼らは権利を与えられるべきです

ロボットを電子人間として扱うには早すぎる

未来のロボットが「十分に人間と同様」であれば、たしかに定義上、「人間と同様の権利」を与えられるべきだ、という論理はわかりますね。それが一体どのようなテクノロジー、状況を指しているのか、現時点で想像できないのが問題ですが…。

米Gizmodoが取材した専門家はすべて、このような法案を通すのは時期尚早だ、という点で合意していました。そしてもう一点、議論に値するポイントが存在しています。それはこの書簡でも示唆されています。

それは電子人間のステータスを、実際には人間ではないロボットに与えるという判断を意識的にすることで、人間であることの意義を減らしてしまっている点。そして(尊厳などが与えられる)「ヒト」というステータスに値する、象やイルカ、クジラ、ほかの知能の高い(動物の種として)非人間の動物たちを無視してしまうことになる、という点です。

註:この記事を書いたGeorge Dvorskyは、Ethics and Emerging Technologies研究所(IEET)の「非人間のヒトとしての権利」プログラムのファウンダーであり、議長を務めています

もちろん、LaBossiereさんが指摘するように、だからといって将来、ロボットが真にヒトとして認められるレベルに到達しない、というわけではありません。彼らがもしも自意識を持ち、思考する存在となれば、彼らに人間としてのステータスを認めないのは不公平になるでしょう。

しかし今のところはまだそのような判断をするには程遠い段階です。今法的な電子人間のステータスを与えてしまうのは賢い法的手段のように聞こえるかもしれませんが、実際はより深い思考や議論を避けるための怠惰な逃げ道です。ロボットやAIから人間や人間の所有物を守るのが目的であれば、もっと理に適った、現実に即した解決策を思いつくべきです。

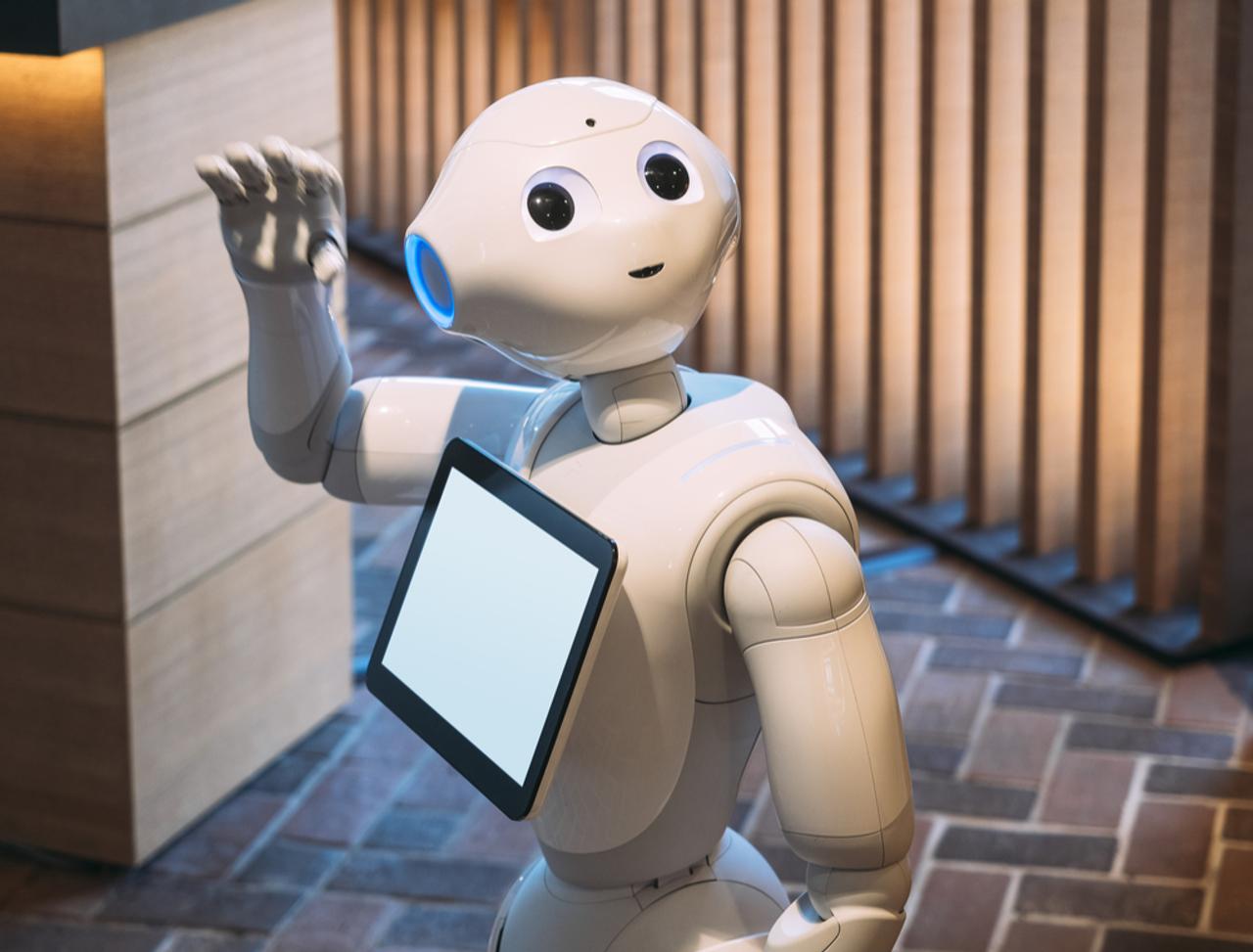

Image: VTT Studio/Shutterstock.com

Source: European Parliament

George Dvorsky - Gizmodo US[原文]

(塚本 紺)